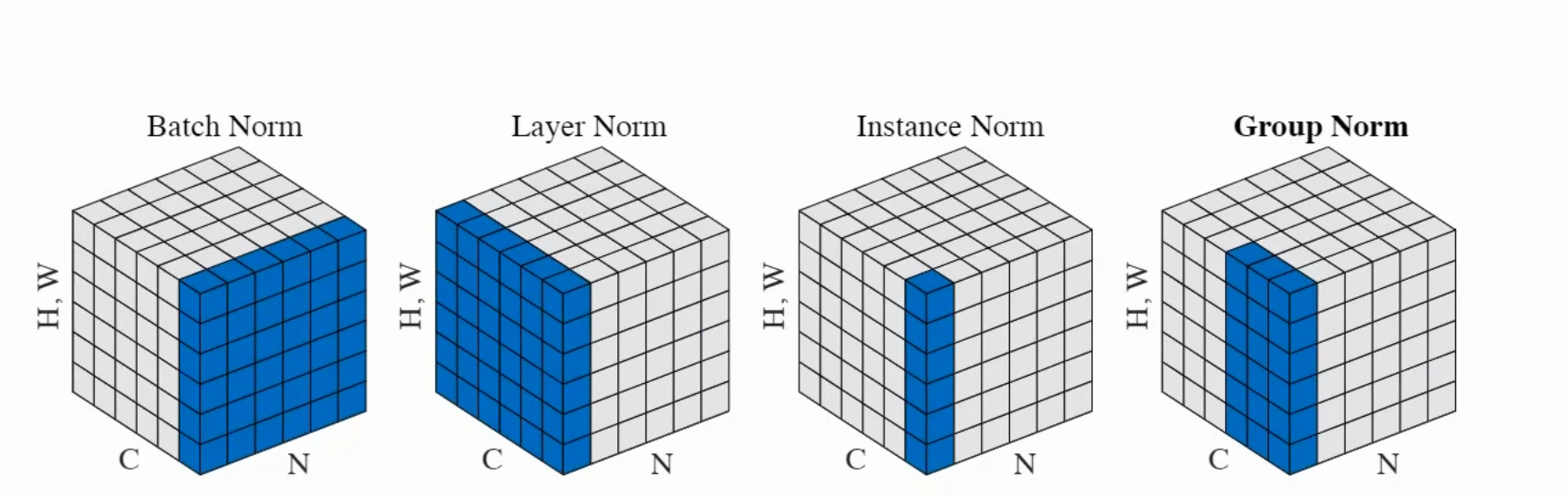

归一化的方法

Batch Norm

- 按照不同的通道进行批归一化;

- 比如输入是【2,3,4,5】,输入两张三通道的图像,取这两张图像的第一个通道组合起来做一次归一化,取这两张图像的第二个通道组合起来做一次归一化……

1 | import torch |

Layer Norm

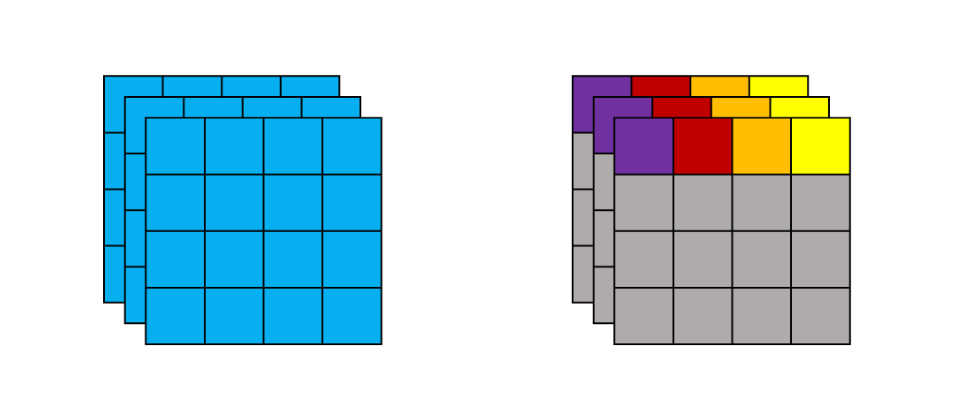

假设我们的输入为(1, 3, 5, 5)的变量,并对其进行LayerNorm,一般来说有两种归一化的方式。如下图所示,左边为第一种归一化方法,对所有channel所有像素计算;右边为第二种归一化方法,对所有channel的每个像素分别计算

- 计算一个batch中所有channel中所有参数的均值和方差,然后进行归一化,即(3, 5, 5)

- 计算一个batch中所有channel中的每一个参数的均值和方差进行归一化,即(3, 1, 1),计算25次